A vártnál is népszerűbbek: a legjobb hangalapú kezelőfelületek titka

A VUI, azaz hangalapú kezelőfelület segítségével kommunikáló személyi asszisztensek sokkal népszerűbbekké váltak, mint amire eleve számítottak a legnagyobb iparági szereplőknél. Az Amazonnál, a Microsoftnál, a Google-nél, vagy az Apple-nél egyaránt megtaláljuk a kínálatukban a saját fejlesztésű digitális asszisztenst, és igazán mindegyik jobb valamiben a versenytársakhoz képest.

Jellemző a kínálatra, hogy akadnak eszközök, amelyek képesek valamelyest jobb ügyfélélményt nyújtani, dacára annak, hogy a riválisok akár évtizedekkel is több tapasztalattal bírnak a hangalapú vezérlés és a hangfelismerés világában. A titok nyitja nem a marketingben vagy a formatervezésben rejlik, hanem a feladat megközelítésében.

Cikkünk azt mutatja be, miként válhatott piacvezetővé és közkedveltté a Microsoft Cortanája, a Google Assistant, vagy a Siri és az Echo, és miként lehet kiemelkedni még ebből a mezőnyből is.

A digitális személyi asszisztensek hajnala

A hangalapú kezelőfelületek, illetve az egyes rendszerek hang alapú interakcióval történő kezelés ötlete nem újdonság. Olyannyira nem, hogy az ókori és újkori mesék világa tele van gépezetekkel, amelyeket hang útján irányítanak.

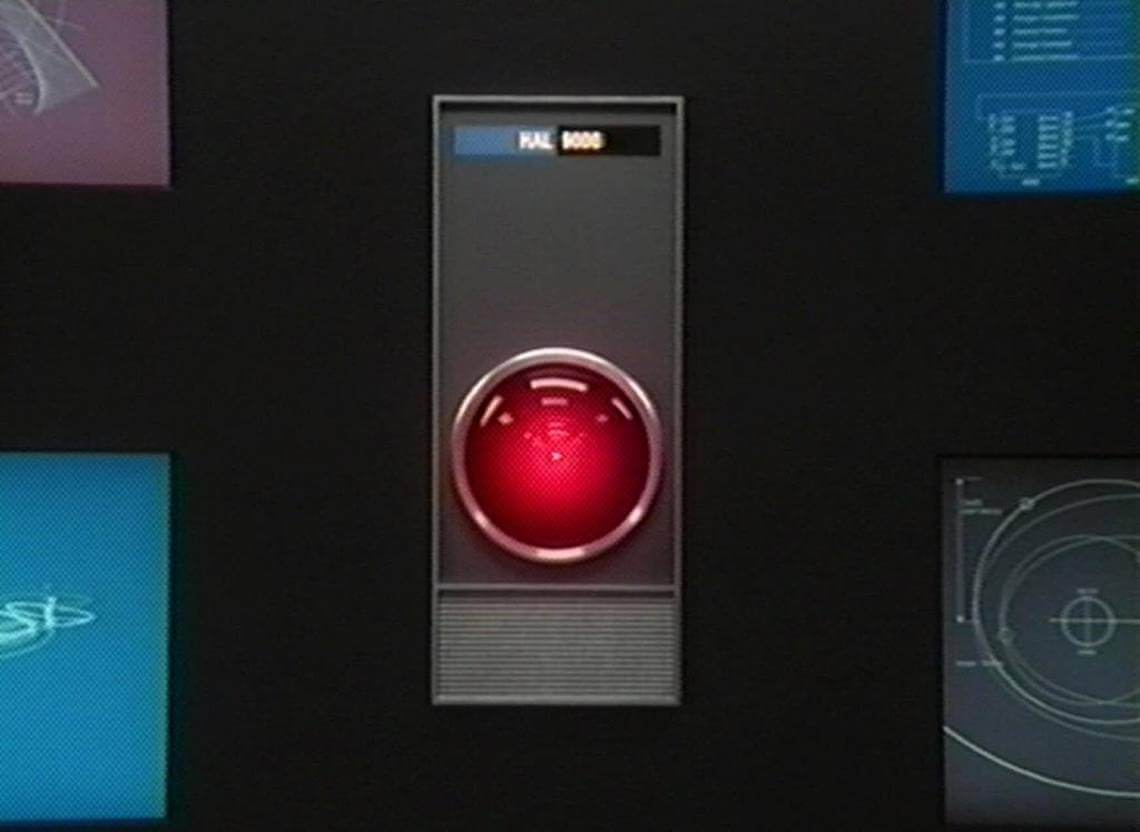

Ali baba a kincsesbarlang ajtaját a „szezám tárulj” hangparanccsal nyitja ki. A terülj, terülj, asztalkám erre a hangparancsra ad mágikus módon ételt. Az Űrodüsszeia HAL-ja és a sci-fik minden androidja VUI-val rendelkezik, méghozzá kontextuális párbeszéd alapú VUI-val: képesek értelmezni a kérdéseket a korábbi interakciók alapján.

A technológia azonban csak a huszadik század végén jutott oda, hogy ténylegesen meg is valósíthatta a hangvezérlésű, digitális személyi asszisztenseket. A jelenből főként Josh Clark Magica UX elképzelése érdemel említést, amely lényegében bármit kezelőfelületként képes felhasználni a ’dolgok internete’ rendszerekben, méghozzá úgy, hogy pusztán szavakkal és gesztusokkal irányítjuk a dolgokat, a távolból.

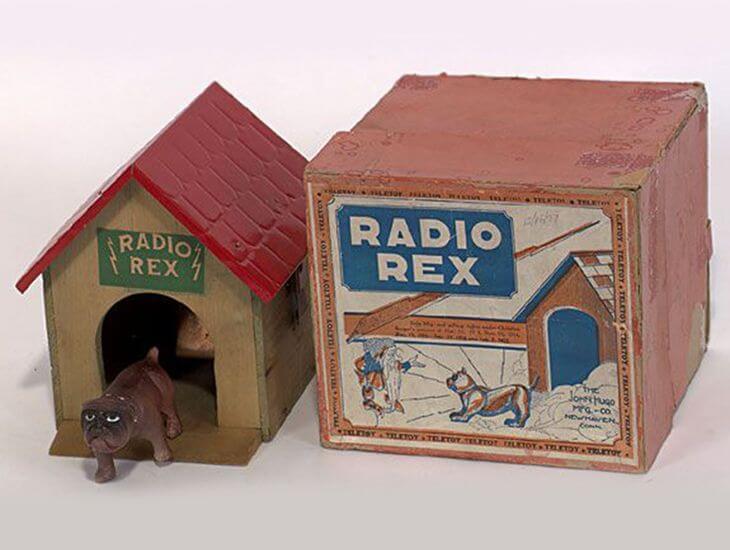

Persze, hangvezérlésű eszközök, vagy az interakcióra képes rendszerek már jóval korábban megjelentek: az első egy játék volt, Radio Rex névre hallgatott. Felismerte, ha kimondták a nevét és kijött a kutyaházából. Mindezt 1911-ben. A Bell Labs 40 évvel később rukkolt elő az első valóban használható, hangfelismerő géppel, Audrey-val, aki a nevét az Automatic Digit Recognition (Automatikus Számjegy Felismerő) gép elnevezés adta.

Az első chatbot 1966-ban debütált, ELIZA névre hallgatott és lehetővé tette az ember és gép közötti interakciót, majd tíz évvel később az amerikai védelmi minisztérium kifejlesztette a „Hárpiát”, ami már ezer szót volt képes felismerni.

A kilencvenes évek hozták meg az áttörést a digitális asszisztensek sorában

A nyolcvanas-kilencvenes években többek között az IBM, a Dragon, a Philips jött elő jelentős fejlesztésekkel a hangfelismerés és hangalapú interakciós megoldások terén: az első valódi okostelefon is az IBM nevéhez köthető.

Ez volt az IBM Simon, ami 1994-ben jelent meg a piacon, teljes érintőkijelzővel bírt, emailt és faxot lehetett küldeni vele, sőt egy rajzprogram és egy játék is megbújt az alkalmazások között.

Említésre érdemes még a belga Lernout & Hauspie is, akik szintén jelentős eredményeket értek el a beszédfelismerés terén és később a Dragon-t is birtokló Nuance Communications vásárolta fel a technológiáikat.

Ám az első, valódi digitális asszisztens és chatbot a SmarterChild volt a Colloquis-tól, 2001-ben: a korabeli chatprogramokon (AIM és MSN Messenger) keresztül lehetett interakcióba lépni vele, és képes volt egyszerű kérdésekre választ adni, vagy időpontot bejegyezni naptárba. Igaz, mindezt szöveges parancsokon és interakción keresztül – hangfelismerésre még képtelen volt.

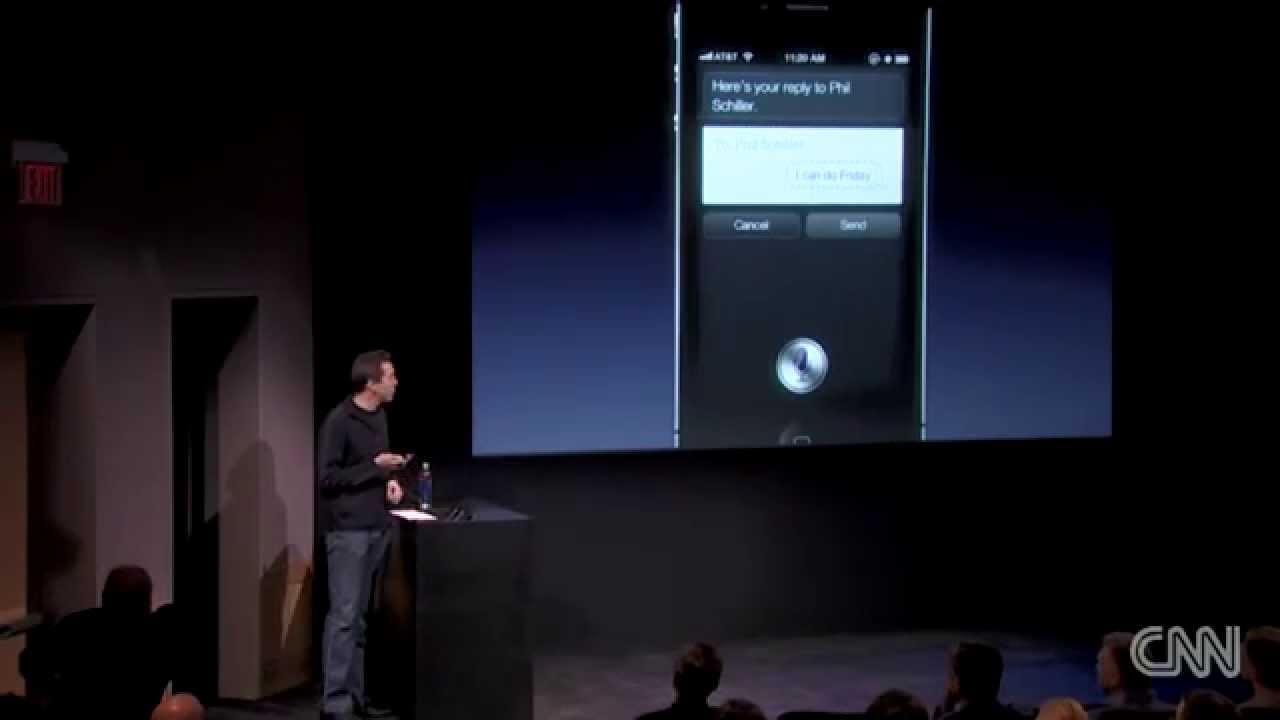

A Siri-vel debütált az első VUI-képes virtuális asszisztens

Ha azonban a legelső, tényleges hangalapú kezelőfelülettel bíró digitális személyi asszisztensre vagyunk kíváncsiak, akkor érdemes bekapcsolni bármelyik, 4S modell utáni iPhone-t, mert ott fülel rajta.

Sirit az Apple mutatta be még 2011 októberében. Természetesen, mint a modern IT iparban megszokott, ez sem az Apple saját találmánya volt. A Siri Inc. felvásárlásával jutottak hozzá és fejlesztették tovább.

Siri és Cortana bemutatkozik, avagy színre lépnek a „lányok”

Eredetileg egyszerű feladatok elvégzésére volt képes hangalapú utasításokat követve, mint SMS küldése vagy telefonhívás indítása, de hamar komplex asszisztenssé fejlesztették, és így Siri már képes volt böngészni a neten vagy étterem ajánlókat adni.

Csakhogy a kezdetektől komoly kritikák érték az Apple-t, hogy Siri nem mindig képes értelmezni a kérdéseket, vagy éppenséggel csak egyetlen időzítőt lehet rajta beállítani. Ez pedig oda vezetett, hogy esetenként egyszerűbb a hangvezérlés helyett szövegesre váltani.

Siri minden hibája ellenére rendkívül népszerű lett, és így hamarosan az Apple két legnagyobb riválisa, a Microsoft és a Google is kihozta a saját VUI-képes virtuális asszisztensét.

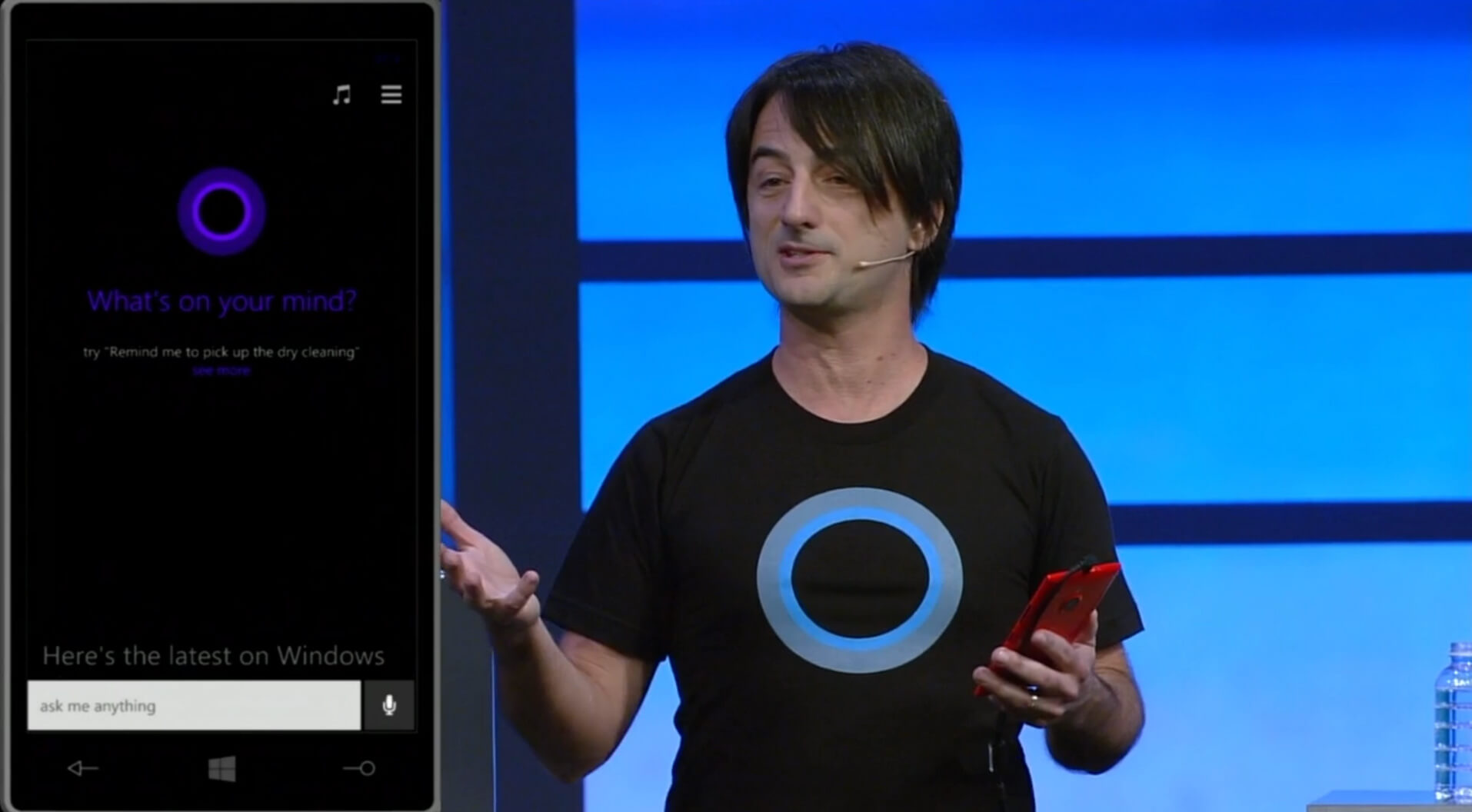

A Microsoft Cortanája 2014-ben vált elérhetővé a nagyközönség számára. A gamerek számára ismerős volt a neve, hiszen a szintén Microsoft által 2001-ben kiadott Halo című játékban Cortanának hívták a digitális asszisztenst, sőt, ugyanaz a színésznő, Jennifer Lee Taylor adta a hangját az amerikai-angol változatának, aki a játékbeli Cortanának is.

A Google asszisztense „gendersemleges” lett, de tud beszélgetni is

A Google Assistant 2016-ban került a piacra, és a többi cégtől eltérően se fiú se lánynevet nem kapott, ugyanakkor az egyik legfejlettebb VUI-n és szöveges felületen keresztül irányítható digitális asszisztens. Eleinte annyit tudott, mint a Siri, de mára már egy komplex rendszerré nőtte ki magát, ami immáron képes különféle eszközöket is kezelni és egyre több okoseszközben elérhető.

Alapfunkcióit tekintve ugyanarra képest, mint a Google Now, viszont hatalmas előnye, hogy az időközben hozzáadott Duplex révén képes szintetizált beszédhanggal is válaszolni, sőt emberi beszédet imitálva intézni el a rábízott feladatokat – például időpontot tud foglalni egy étteremben, úgy, hogy az éttermi dolgozó nem is feltétlen veszi észre, hogy egy géppel beszélt.

Igaz, a meglehetősen futurisztikus képet némileg árnyalja, hogy a hívások negyedét valójában emberek végezték, illetve a párbeszédek 15 százalékában ember vette át a gép helyét a beszélgetés folyamán.

Harcos lány helyett készséges asszisztens: az Amazon Alexája

Az Amazon szintén 2014-ben tette elérhetővé a saját VUI alapú asszisztensét, az Alexát, bár igazán 2016-tól kezdett elterjedni, amikor piacra dobták az Echo-t, azt a készüléket, amely igazi otthonvezérlő központként is tud működni, amellett, hogy személyi asszisztensként számos szolgáltatást nyújt, tisztán hang alapú vezérléssel.

Miként lehet az, hogy bár az Amazon csak 2014-ben debütált Alexával és az Echo-val, mégis hamarosan, 2017-től kezdve ez az online kereskedelmi óriás kezdett nyílt tervező szolgáltatást nyújtani, ami által bárki megvalósíthatja a saját, digitális asszisztensekben is alkalmazható, párbeszédre építő kezelőfelületét? És egyáltalán: mitől válik igazán kiemelkedővé egy VUI alapú eszköz?

Az Amazon Alexája az Echoba költözik

Az Echo nyújtotta szolgáltatások listája a zene- és hangoskönyv lejátszástól kezdve a tennivaló listák készítésén át egészen az okosotthonok irányításáig terjed. Mindez olyasmi, amire egyébként a Siri vagy a Google Assistant is képes (lehet).

A népszerűség titkának a nyitja, a legfőbb ok, ami miatt az Alexa az Echo-n keresztül sikeresebb lehetett, mint az Apple Sirije, hogy ez utóbbit csak az „iTermékek” másfajta kezelésére tervezték. A Sirivel és a Google-lel ellentétben az Echo célzottan a VUI-n keresztüli interakciót szolgáló fejlesztés, ami a hangalapú kezelést helyezi minden más fölé!

Az Echo használata során a tervezők az emberi párbeszédből indultak ki, és kifejezetten úgy alkották meg a VUI-t, hogy tudták, eleinte csak hanggal lehet majd vezérelni a rendszert. Létfontosságú volt tehát, hogy Alexa tökéletesen értse az emberi beszédet és képes legyen kontextusban értelmezni, képes legyen lényegében párbeszédet folytatni.

Hound: a szövegkörnyezetet értelmező „kopó”

Egy másik cég, a 2005-ben alapított SoundHound volt az, aki az Alexához hasonló szoftvert dobott a piacra: ez a Hound, amely szintén képes a természetes emberi beszédet megérteni. 2015-ben messze összetettebb megértésre volt képes, mint a Siri: már akkor teljes szövegkörnyezetet értelmezett és a felhasználók valós szándékát is jobban értelmezte, mert a kimondott kérdést csak alapul vette.

A Hound sikerét talán az mutatja meg a legjobban, hogy olyan cégek kezdték finanszírozni a fejlesztőket, mint a Tencent, az Nvidia, a Samsung a Daimler vagy a Hyundai.

Hogyan érdemes felépíteni egy VUI-t az alapoktól, hogy igazán sikeressé váljon?

Az eddig felhozott példák talán jól szemléltetik, mi a döntő különbség a digitális asszisztensek között. Az egyik irány, aminek a fő képviselője a Siri és a Cortana, a mellérendelt VUI jellemzi, a másikat, amiben az Alexa és a Hound jeleskedik, a VUI elsődlegessége.

Amikor VUI tervezésre kerül a sor, az Ergomania is elsősorban ezt az irányzatot képviseli, ugyanis az elmúlt évek során egyértelműen bebizonyosodott, hogy a felhasználók is sokkal szívesebben használnak olyan VUI alapú eszközöket, amelyeket elsődlegesen hangirányítású, kontextuális rendszernek alkottak meg.

Következzenek most azok a szempontok, amelyek által létrehozható egy Houndhoz vagy Alexához hasonlóan népszerű megoldás.

A hangfelismerés alapja az SR helyett az NLU

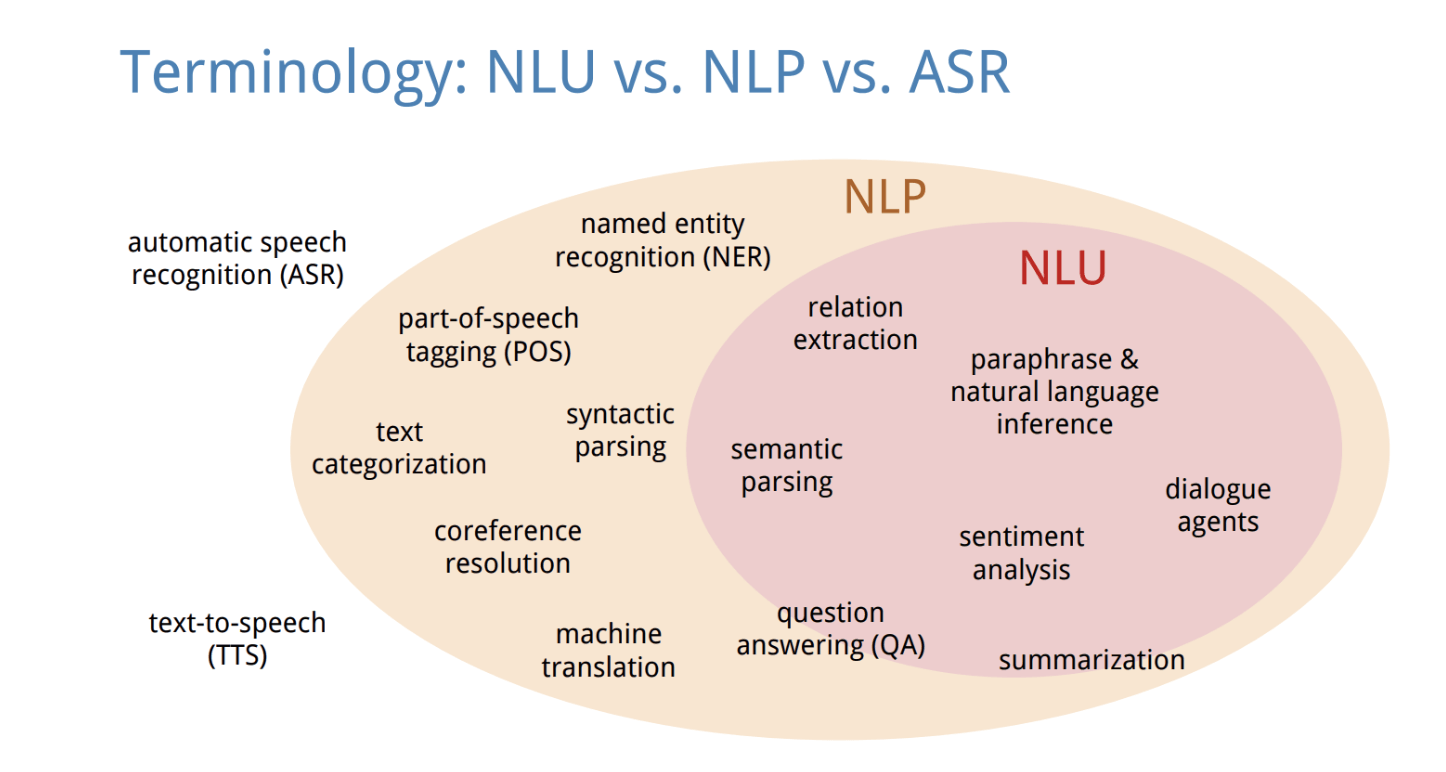

A természetes szövegértés (natural-language understanding, röviden NLU) abban tér el a szövegfelismeréstől (speech recognition, SR), hogy az elhangzó szöveget annak értelmezési környezetében, kontextusában vizsgálja. Annyira fejlett az emberi szöveg felismerése és a szavak megértése, hogy manapság már sokkal inkább az NLU-n van a hangsúly, mint a kimondott szavak „felfogásán”.

Ebből következik, hogy például az egyszavas válaszokat igénylő kérdéseknél a legjobb rendszerek képesek kezelni a nem sztenderd feleleteket is. Például az „igen” helyett elfogadja, azonos értelemmel a „persze”, „naná”, „ja”, „aha” válaszokat is.

Párbeszéd kezelése

Az Ergomania szakemberei, amikor igazán jól, rugalmasan használható VUI-t terveznek, a „párbeszéd menedzselésére” fektetnek több energiát. Ez magába foglalja mindazt, ahogy a rendszer kezeli a párbeszéd során már megismert információt és választásokat és azt, hogy mi kéne következzen az adott cél elérésének érdekében.

A rendszer ezért folyamatosan jegyzi, hogy milyen további információkra van még szüksége és ezekre milyen sorrendben kérdezzen rá. Érdemes ezt úgy elképzelni, mint egy rendelési folyamatot, ahol több tényező is az ügyfelen múlik. Például jegyvásárlásnál a rendszer sorban rákérdez, hogy milyen típusú jegyet, mikori érvényességgel, milyen azonosító számmal stb. akar venni.

A klasszikus megoldás a statikus sorrend, amikor az ügyfél nem térhet el a rendelés menetétől – a modern VUI szemlélet viszont hagyja, hogy az ügyfél maga döntsön az információ átadás sorrendjéről, a rendszer dolga az, hogy nyomon kövesse, mi hiányzik még és ezekre rákérdezzen.

A szövegkörnyezet szerepe

Az Ergomaniánál több esetben is találkoztunk olyan VUI fejlesztési felkéréssel, ahol a kontextus, azaz a szövegkörnyezet kezelése jelentette az egyik fő kihívást. A chatbotok és virtuális asszisztensek számára is a kontextus az, ami kritikus a megfelelő működéshez, mert kezelniük kell a korábban elhangzott információkat és „fél szavakból” is érteniük kell a felhasználót – gyakran előbb kitalálva, mire gondolnak, mint ők maguk.

Például a rendszer felkészülhet arra, hogy ételt rendelnek rajta keresztül (ez meglehetősen gyakorivá vált a karantén során), és ekkor érdemes előzetesen tájékozódnia, hogy a felhasználó hol tartózkodik, mert ez alapján ajánlhat éttermet.

Az pedig külön növeli az ügyfélélményt, ha hosszú távon is megjegyzi a rendszer a közölt információkat, így egy rendszeresen visszatérő kérdésre adott eltérő válaszok esetén eltérően reagálhat úgy, hogy hivatkozik korábbi állapotokra.

Például a „hogy aludt” kérdésre kapott ügyfélválaszok alapján javasolhat dolgokat a rendszer, utalva a korábbiakra: „korábban jól aludt. Valami nyugtalanítja?”

Mindez ráadásul jelentősen növeli az ügyfélélményt, mert a felhasználó számára a rendszer több lesz, mint egy „buta számítógép”: inkább egy bizalmas, aki odafigyel rá.

A hívószó kérdése

Apró tényezőnek tűnik, ám valójában fundalmentális kérdés a hívószóé, amivel aktiválni lehet a rendszert. Az „OK, Google”, vagy „Alexa” két remek példa arra, hogy olyan aktiváló hangparancsra van szükség, ami:

- könnyen megjegyezhető,

- élő beszédben nagyon ritka,

- a rendszer könnyen megérti,

- nem keverhető össze más parancsszóval.

Az Amazon például rengeteg erőforrást fordított arra, hogy az „Alexa” szót jól érthesse az Echo: mivel az Alaszka szó nagyon hasonló hozzá, ha túlérzékeny a rendszer, sokszor aktiválódik (Amerikai célpiacról beszélünk), ha viszont pontos kiejtést vár, akkor meg az ügyfelek frusztráltságát növeli, ha többször is ki kell mondaniuk az Alexa szót, mert a rendszer teljesen biztosra akar menni.

Az „OK, Google” esetében szintén kiejtési-értési probléma adódott: a ’k’ és a ’g’ hang annyira közeliek, hogy aki nem angol anyanyelvű, hogy ’okéj gúgl’-nek ejtse, hanem inkább ’ok gugli’-t mond, a közeli ejtésű hangok miatt a rendszer tanácstalanná válhat, hogy most aktiválni akarták-e vagy sem.

Már ennyiből is látható, hogy egy modern, hangalapú kezelőfelület megtervezése messze több tudást, technológiai hátteret és felkészülést igényel, mint akár tíz évvel ezelőtt is. Ha biztosra akar menni, vegye fel a kapcsolatot itt az Ergomania-val, a kezelőfelületek szakértőjével!

Mind a 1 hozzászólás mutatása

ajánlott

cikkek

Tudj meg többet a témáról

1 hozzászólás

Oszd meg velünk véleményed

A hang alapú azonosítás a jövő biometrikus azonosítója | UX design ügynökség - Ergomania Budapest | 2021. Jun. 08.

[…] az ügyfélszolgálati csatornákon, vagy a mobilbankok esetében vagy éppen a digitális asszisztensek használata során (például Alexa, Google Assistant) érkező lekérdezések […]